Роботы и угроза: как предотвратить риск «восстания машин»

На протяжении всей истории человечества технический прогресс, помимо благ, всегда нёс с собой и угрозы: пассажир бесспорно выигрывает от появления автомобилей, но при этом рискует пострадать под его колёсами. Сегодня мы находимся на новом витке развития, когда прогресс в области робототехники ставит перед нами новые и непростые вопросы.

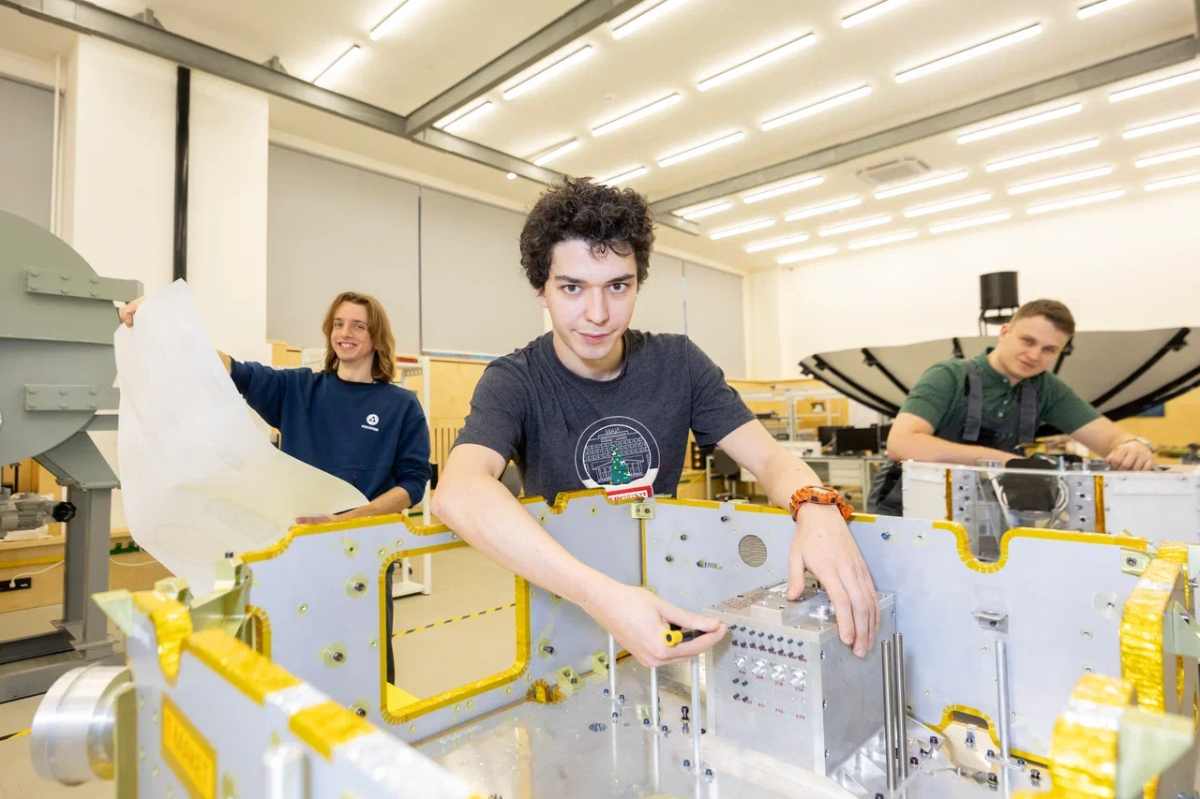

Фото: Пресс-служба МАИ / Личный архив

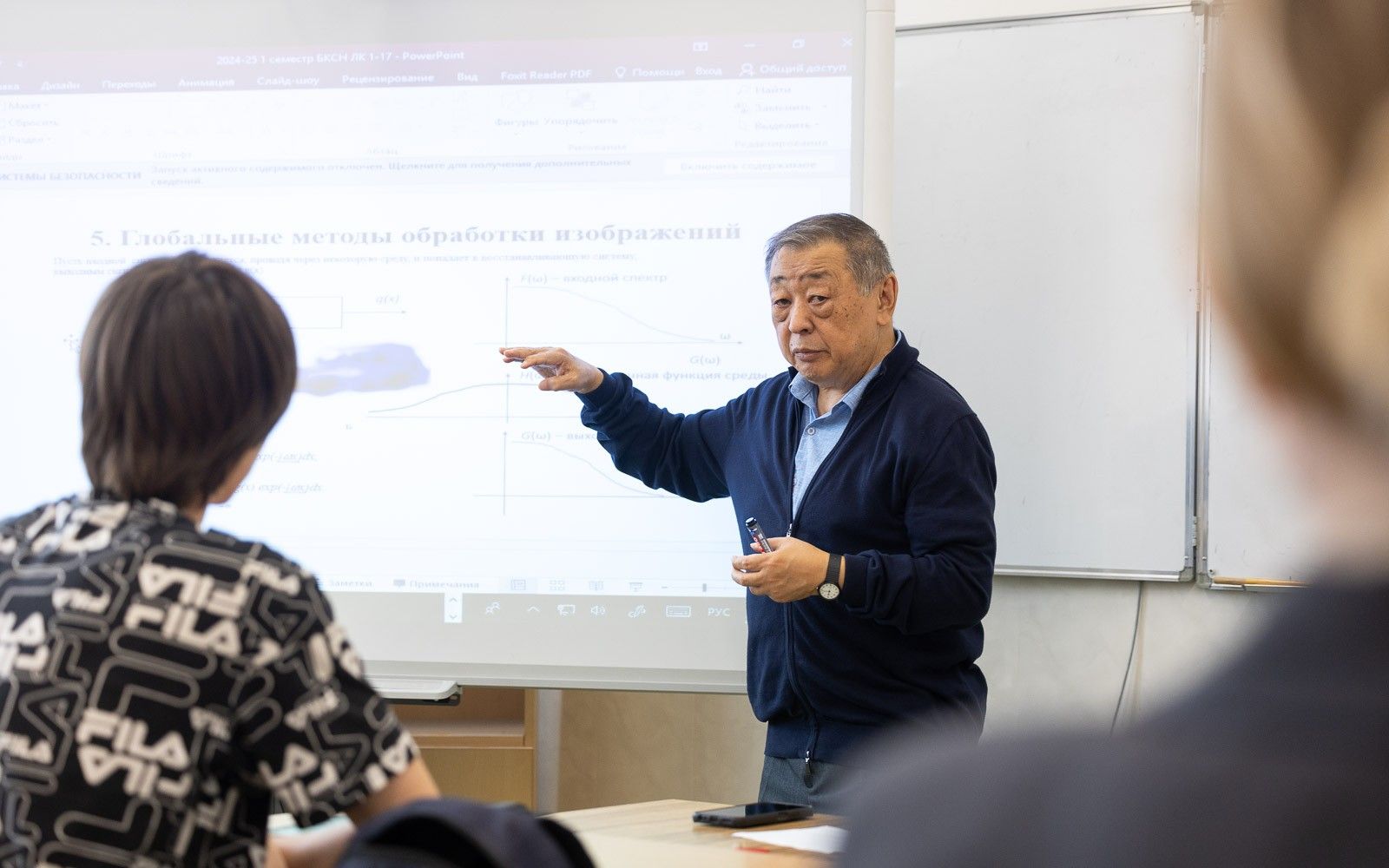

Фото: Пресс-служба МАИ / Личный архив

Один из них: какие угрозы таит в себе этот перспективный вид техники, профессор кафедры 704 «Информационно-управляющие комплексы летательных аппаратов» МАИ, кандидат технических наук Николай Ким.

Тема «восстания машин» популярна в научной фантастике, и многие эксперты в мире считают, что эти страхи имеют под собой реальное основание. Благодаря развитию «сильного» искусственного интеллекта роботы научатся ценить своё существование как важное для выполнения возложенных на них задач. Таким образом, прежде бездушные механизмы получат нечто похожее на биологический инстинкт самосохранения, который при определённых условиях может вызвать отношение к человеку как к угрозе и соответственно спровоцировать ответные агрессивные меры.

— Любое внедрение в нашу жизнь революционных технологий, в том числе робототехнических, сопровождается конфликтами между различными группами людей. Вспомним, например, движение луддитов в XIX веке. Эти конфликты не зависят от уровня интеллекта роботов. Пока роботы оснащены относительно низким уровнем интеллекта, суть конфликтов будет определяться возможным различием интересов, в частности, владельцев обслуживающих роботов и пользователей. Опасность конфликтов человек — робот будет возрастать при внедрении в роботов инстинкта самосохранения и, что ещё более важно, появлении возможности их самоидентификации, собственных мотиваций, — отмечает эксперт.

Хотя переход к «сильному» ИИ — это ещё достаточно отдалённая перспектива, уже сейчас искусственный интеллект роботов может идти наперекор интересам конкретного человека или группы людей.

— На самом деле даже обычные роботы, которые есть сейчас, например, водители беспилотных автомобилей, уже имеют заложенные разработчиком предпочтения. И эти предпочтения, например, получение максимальной выручки с клиента, могут идти вразрез с нашими. Здесь и проявляется конфликт «робот — человек», потому что робот будет выполнять функции, в которых заложено получение максимальной прибыли, а пассажир будет заинтересован в получении чека на минимальную сумму. Как этот конфликт будет разрешаться? Пока мы не знаем, но вполне возможно, что робот убедит пассажира в своей правоте. Такие конфликты с развитием искусственного интеллекта будут нарастать в самых разных сферах его применения, — считает Николай Ким.

Такого рода риски особенно высоки в среде коллаборативных роботов, которые могут работать в непосредственном контакте с человеком. Именно в них прежде всего будут закладываться функции самостоятельного принятия решений, а их деятельность будет непосредственно сказываться на людях.

Но можем ли мы предотвратить риски, проистекающие от слишком умных и самостоятельных роботов?

В определённой степени можем, считает эксперт, если законодательно регулировать степень применения искусственного интеллекта. Когда изобрели автомобили, законодательство всех стран мира ввело ограничения на скоростной режим при их использовании. Когда появилась авиация, ввели воздушные коридоры, чтобы самолёты не сталкивались друг с другом. Точно так же и в робототехнике: с развитием техники с искусственным интеллектом необходимо вводить определённые ограничительные стандарты.

— Сейчас такие стандарты введены в коллаборативной робототехнике: например, на недопустимость соприкосновения с человеком с определёнными скоростями. Однако подобные меры не могут полностью исключить риски с развитием искусственного интеллекта, особенно в отношении отдельных компаний или разработчиков. Трудно абсолютно всех игроков заставить делать то, что договорились делать во всём мире: не повышать уровень интеллекта до слишком высокого уровня — отмечает эксперт.

Однако стратегической проблемой развития и широкого внедрения робототехники и искусственного интеллекта остаётся сложность долгосрочного прогнозирования возможных, в т.ч. глобальных последствий. Человечество только учится пользоваться новыми возможностями. Так что риски в любом случае остаются.

Материал подготовлен при поддержке Минобрнауки России.