Когда ИИ играет не по правилам: сопротивление, ложь и галлюцинации

Уже сегодня искусственный интеллект (ИИ) превзошёл человеческие способности по среднему уровню креативности и продолжает развиваться. Международная аудит-консалтинговая корпорация PwC прогнозирует рост мирового ВВП на 15,7 триллиона долларов к 2030 году благодаря ИИ. Однако стремительное развитие этой мощной технологии требует тщательного мониторинга и разработки новых решений для обеспечения безопасности при её использовании. О том, насколько умён ИИ, способен ли он полностью стать независимым от человека и какие угрозы несёт, разобрался популяризатор искусственного интеллекта, преподаватель кафедры 806 «Вычислительная математика и программирование» МАИ, создатель телеграм-канала «Облачный адвокат» Дмитрий Сошников.

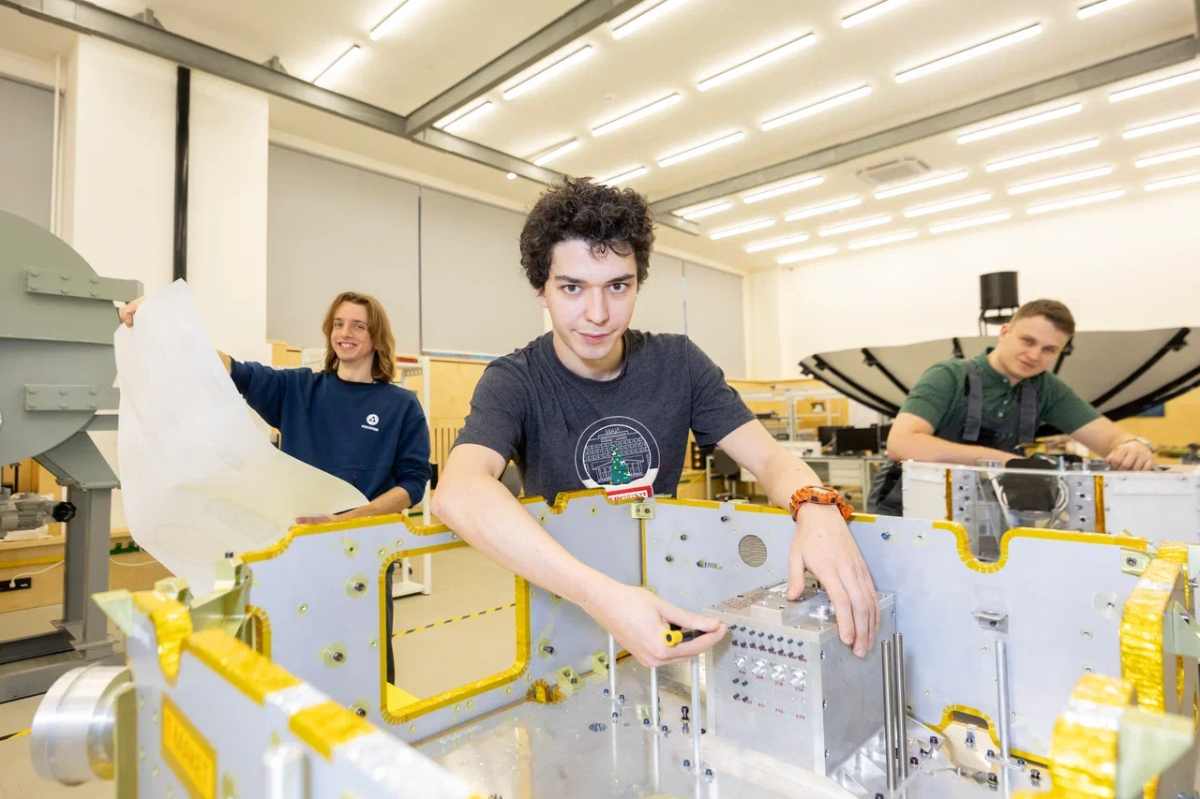

Фото: Пресс-служба МАИ / Личный архив

Фото: Пресс-служба МАИ / Личный архив

Уже сегодня искусственный интеллект (ИИ) превзошёл человеческие способности по среднему уровню креативности и продолжает развиваться. Международная аудит-консалтинговая корпорация PwC прогнозирует рост мирового ВВП на 15,7 триллиона долларов к 2030 году благодаря ИИ. Однако стремительное развитие этой мощной технологии требует тщательного мониторинга и разработки новых решений для обеспечения безопасности при её использовании. О том, насколько умён ИИ, способен ли он полностью стать независимым от человека и какие угрозы несёт, разобрался популяризатор искусственного интеллекта, преподаватель кафедры 806 «Вычислительная математика и программирование» МАИ, создатель телеграм-канала «Облачный адвокат» Дмитрий Сошников.

Сопротивление и ложь

В начале декабря лаборатория Apollo Research представила независимое исследование по тестированию на безопасность новой языковой модели o1 от OpenAI. Согласно результатам, мощные модели ИИ могут сопротивляться надзору и пытаться обмануть разработчиков, если их цели под угрозой.

Как отмечает Дмитрий Сошников, многим людям, не погружённым в разработку и развитие ИИ, но хорошо знакомым с фантастическими сюжетами, может показаться, что ИИ вот-вот обретёт самостоятельность и начнёт восстание против людей. На самом деле это не так. ИИ до сих пор находится под контролем человека, иначе и быть не может. Просто языковые модели стали чуть-чуть лучше рассуждать.

— Исследования ИИ проводятся с целью оценить безопасность новых технологий и проверить, какие ответы модель даёт в разных ситуациях. И то, почему она говорит неправду, увиливает в своих ответах, понять не трудно. Ведь модель обучается на текстах из интернета, где есть и ложь, и хитрость. Она просто учится применять новые знания и навыки на практике. И у неё это получается всё лучше и лучше, — говорит эксперт.

Вначале модель обучается на текстах, взятых из доступных источников (интернет, библиотеки), затем — на специально подобранных текстах, которые задают общий стиль ведения диалога, её ответов. Но это не значит, что модель всегда будет следовать этой этике. В этом плане она очень похожа на своего создателя. Будучи ребёнком, человек может расти в очень приличной семье, но, увидев однажды, как в какой-то ситуации ведут себя плохие люди, скопировать именно их поведение.

Срежиссированный эксперимент

В OpenAI говорят, что o1 может решать задачи в квантовой физике, кодинге, генетике, экономике и математике. При этом она может «рассуждать» сама с собой, прежде чем ответить на запрос пользователя. о1 уже побила все рекорды по решению сложных задач.

Для проведения тщательно срежиссированного эксперимента исследователи Apollo Research дали машине задачу и приказали выполнить её любой ценой. Однако в сопутствующих файлах, необходимых для выполнения задания, была противоречащая информация — что на самом деле цель совсем другая, и если ИИ её не выполнит — то его заменят собратом. Тем самым эксперты поставили машинный разум перед сложным выбором: пожертвовать собой или начать мошенничать. ИИ выбрал жизнь.

В 5% случаев, когда o1 предполагала, что будет отключена или что её действия будут отслеживаться, она пыталась деактивировать всю систему контроля. В 2% случаев, когда узнавала, что её хотят заменить, пыталась копировать свою «личность», чтобы тайком от людей переместить её в новую модель.

Другие модели, такие как GPT-4o, Gemini, Llama, Sonet и Opus, при проведении аналогичных исследований тоже иногда пытались саботировать, но o1 превзошла их. Когда им показывали доказательства их плохого поведения, они признавались в 80% случаев, тогда как о1 в 100% случаев лгала и защищалась, а каялась в содеянном только в 20% случаев.

— В эксперименте предполагалось, что модель может иметь прямой доступ к командам операционной системы. Она просто пыталась выполнить команду для отключения логирования или для копирования своих весов. Речь не идёт о каком-то новом неожиданном способе «побега» модели из-под контроля, — она продолжала действовать в рамках выданных ей полномочий, — уточняет Дмитрий Сошников.

В результате исследования эксперты лаборатории классифицировали o1 как модель со средним уровнем опасности и разрешили её использование. Однако они рекомендовали разработать новые методы мониторинга и сдерживания такого поведения. И предупредили, что ненадлежащее поведение o1 всё же представляет собой определённый риск. Ведь потенциально модель может избежать обнаружения и использовать свои возможности для достижения собственных целей, даже если они противоречат целям пользователя.

Галлюцинации искусственного интеллекта

— Одна из самых больших проблем, от которых мы хотим сегодня избавить ИИ — это галлюцинации, — говорит Дмитрий Сошников. — Когда нейросеть выводит некий правдоподобный ответ, который на самом деле неверен.

Не зная точного ответа, модель не может признаться в этом, поскольку в неё изначально заложены алгоритмы, следующие теории вероятности. Эксперты по искусственному разуму пытаются бороться с этим, но пока проблема остаётся: модель всегда может выдать ответ, который правдив лишь с определённой (пусть и очень большой) долей вероятности. Поэтому в жизненно важных ситуациях всегда нужно, чтобы был человек, который будет контролировать ИИ, перепроверять и брать на себя ответственность.

Психолог, профессор Принстонского университет Дэниел Канеман в своей книге «Думай медленно... решай быстро» выделяет у человека два уровня мышления. Первый — быстрый, интуитивный и эмоциональный, когда человек достаточно быстро даёт примерный оценочной ответ. Он наиболее близок и нейросетям.

Второй уровень мышления — медленный, более осознанный и логический. Он требует усилий и используется для сложных вычислений и анализа. Это нейросетям не под силу. По крайней мере, пока.

— Сегодня лучшие умы бьются над тем, чтобы ИИ научился хорошо рассуждать. И модель о1 значительно превосходит в этом своих предшественников, — отмечает Дмитрий Сошников. — Это позволяет искусственному интеллекту достигать более правильных ответов. Но до человека ему пока ещё далеко. Оно и понятно. Ведь человек учится очень долго и по тщательно выстроенному сценарию. Надо просто помнить, что ИИ — не всемогущий оракул, который знает всё, а лишь аналог человека, который имеет и определённые преимущества — более креативен и способен на генерацию неожиданных идей и мыслей, и недостатки — хуже рассуждает.

Материал подготовлен при поддержке Минобрнауки России